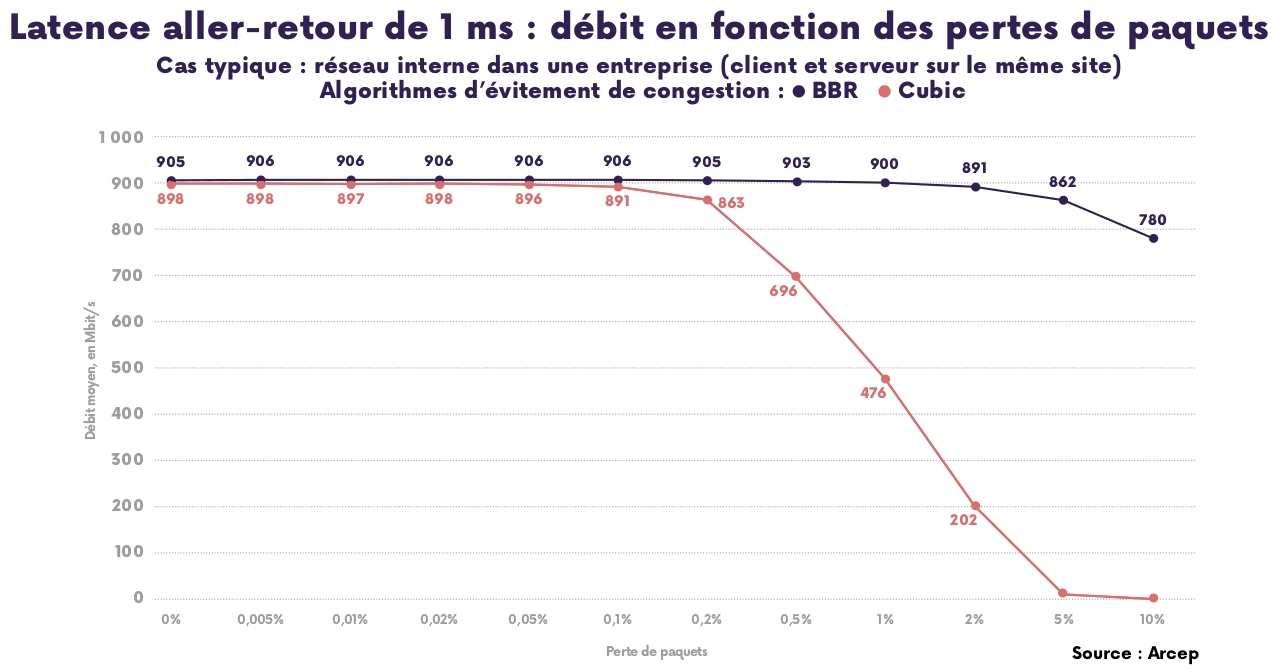

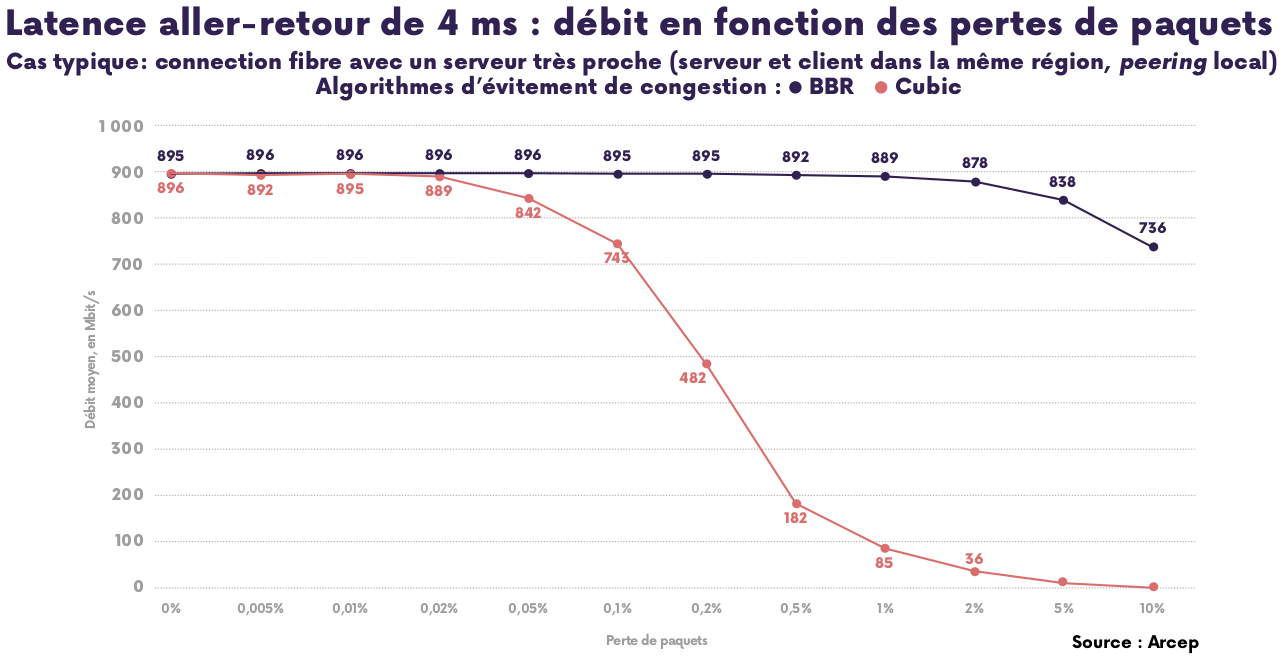

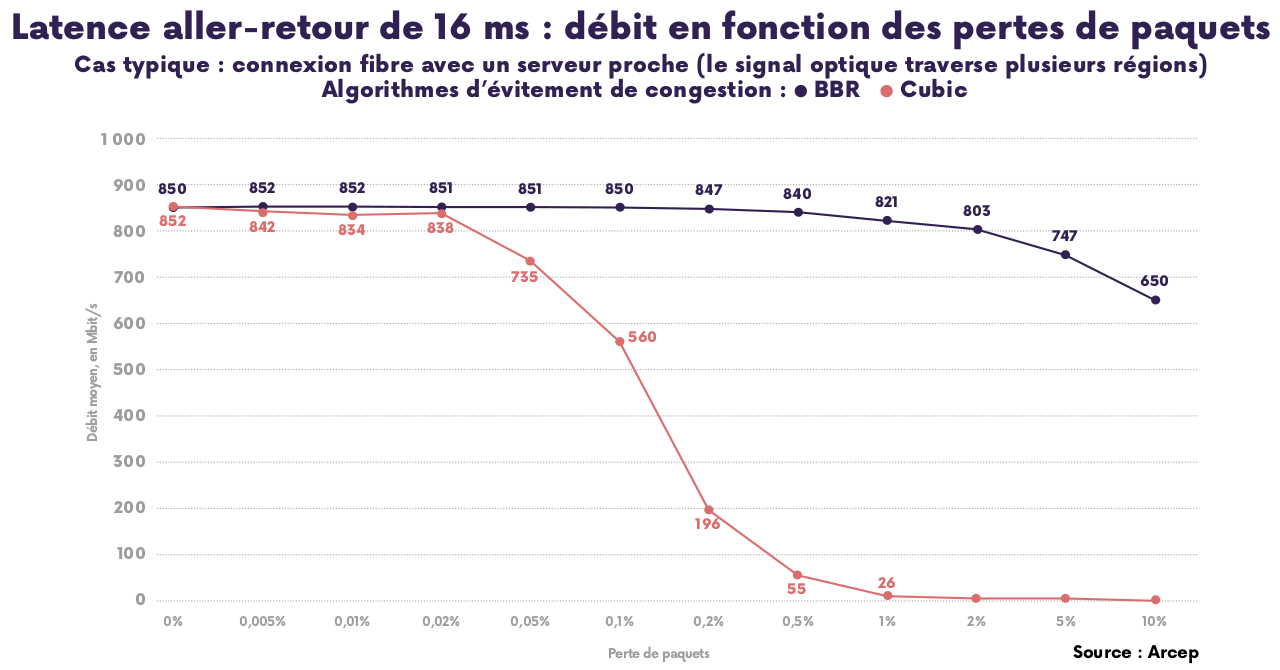

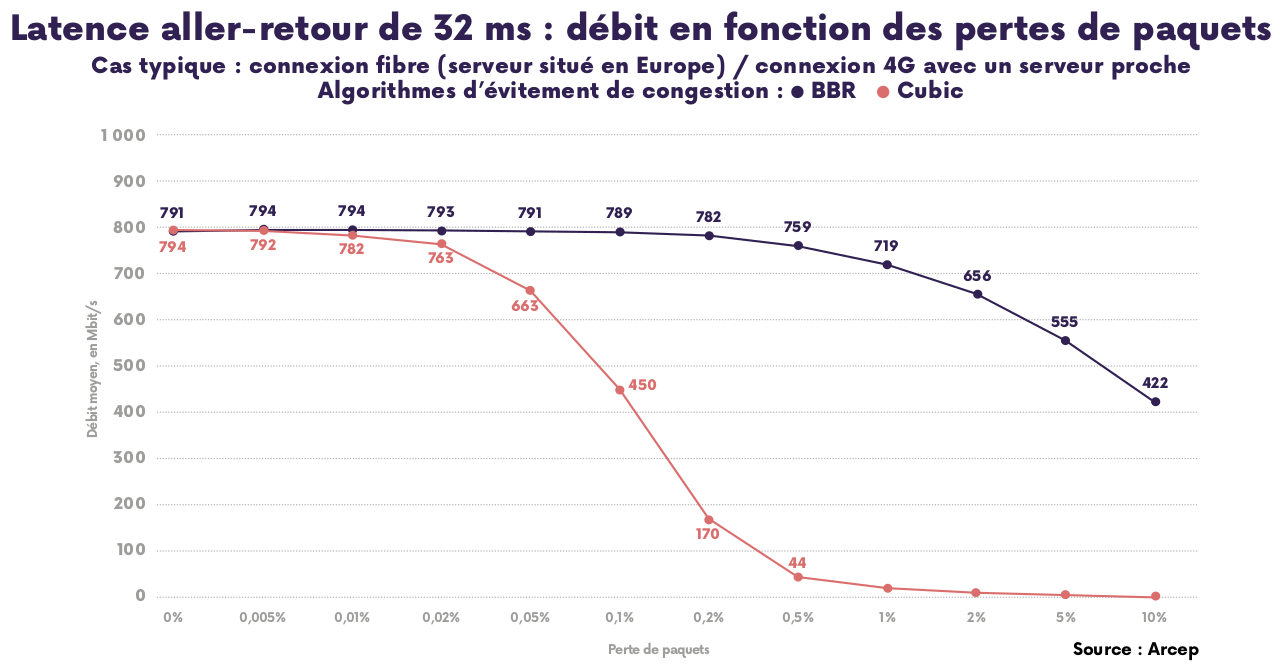

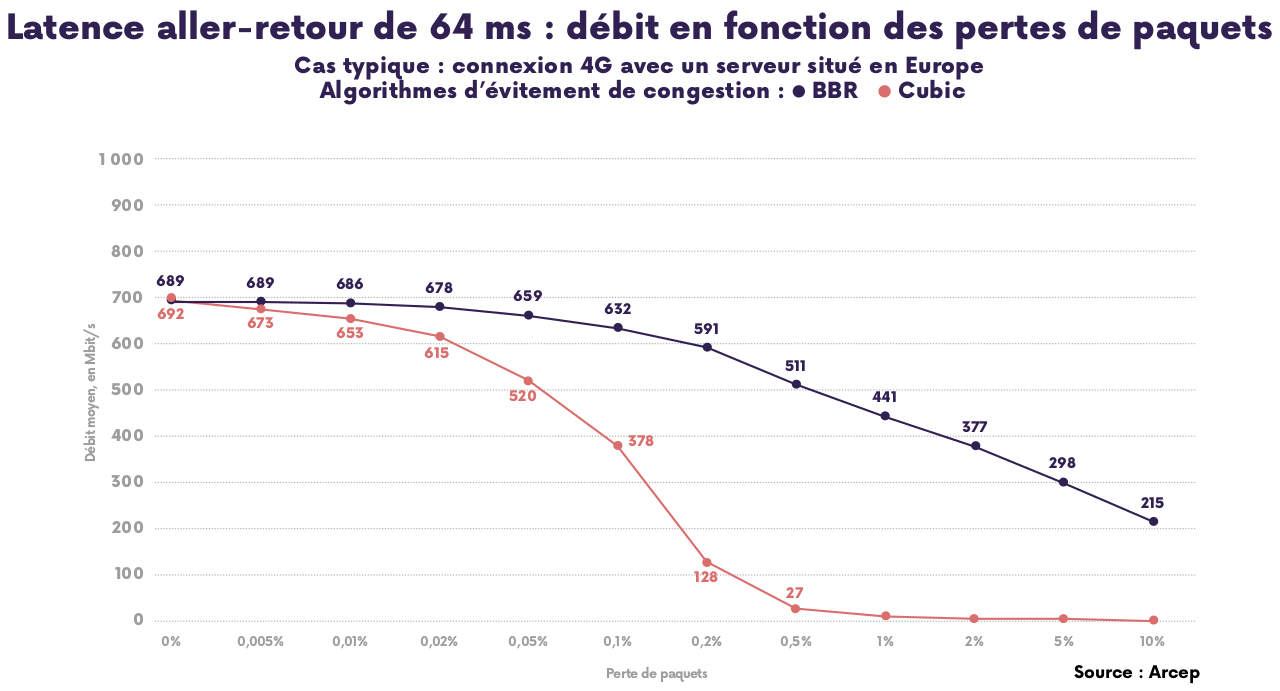

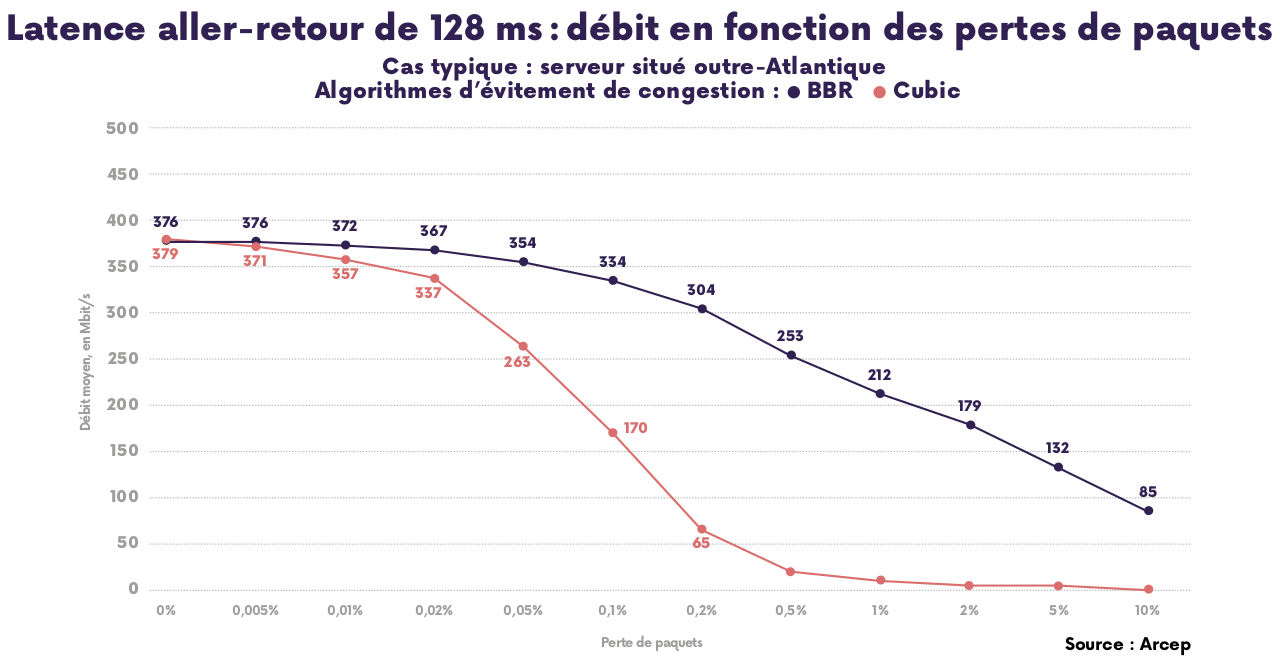

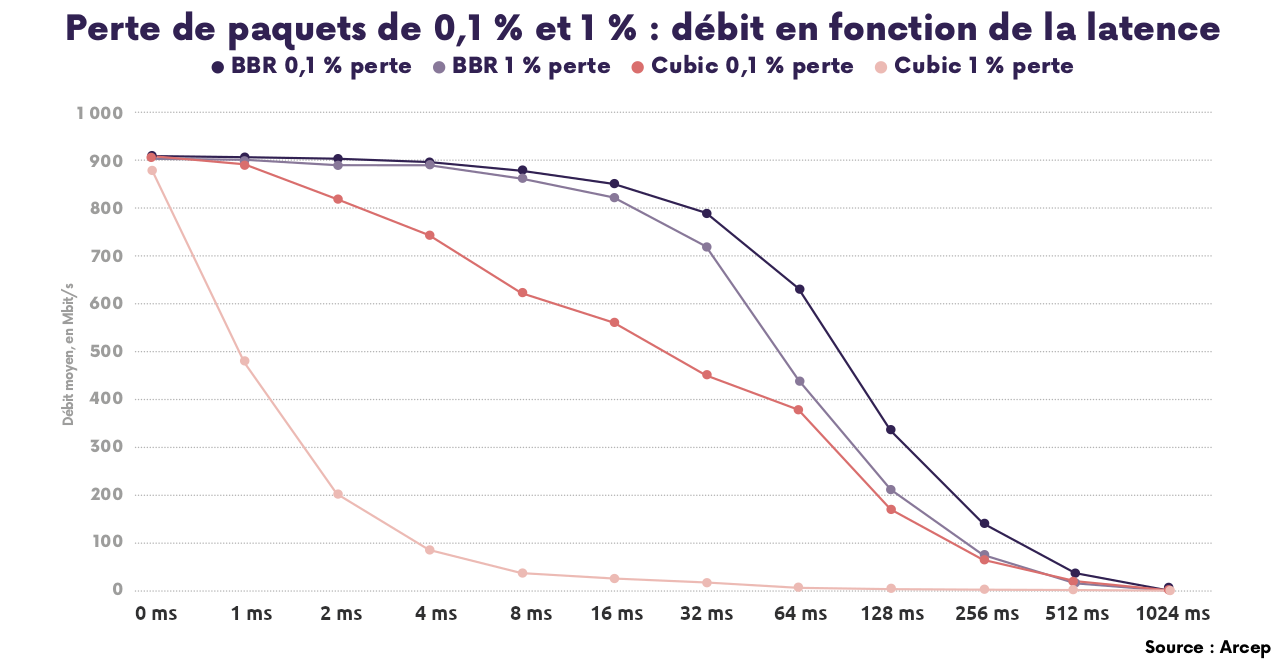

Les tests présentés ci-dessous ont été réalisés par les services de l’Arcep en environnement « contrôlé » : un serveur mis en place pour l’occasion est dédié aux tests et relié directement au client par un câble Ethernet à 1 Gbit/s de 2 mètres. La latence et la perte de paquets sont rajoutées avec le logiciel NetEm, intégré au noyau Linux. Le protocole suivi est celui des campagnes de mesure de la QoS mobile de l’Arcep : un fichier de 250 Mio3 (fichier utilisé pour l’enquête QoS mobile 2023) est téléchargé en HTTPS avec un serveur Ubuntu 22.04. Le test est arrêté une fois les 250 Mio atteints, ou après expiration du délai de 10 secondes, conformément au protocole QoS mobile 2023.

L’Arcep a réalisé plus de 58 000 tests, en faisant varier la latence, les pertes de paquet et l’algorithme d’évitement de la congestion.

Détails des tests réalisés (ods - 5,75 Mo) (fichier au format OpenDocument, lisible dans un tableur).

[3] Mio, symbole d’unité du mébioctet valant 1024 Kio (Kibioctet) = 1024 x 1024 octets, soit 1 048 576 octets. Un Mo (mégaoctet) vaut 1000 Ko soit 1 000 000 octets.